La informática o computación es la ciencia que

estudia los métodos y técnicas para almacenar, procesar y transmitir

informáticas de

manera automatizada, y más específicamente, en formato digital empleando

sistemas computarizados.

No existe realmente una definición única y universal de lo

que la informática es, quizá porque se trata de una de las ciencias de más

reciente origen, aunque de desarrollo más vertiginoso y desenfrenado.

Por eso en muchos espacios académicos suelen diferenciar entre esta disciplina y las ciencias de la computación (o la ingeniería informática), considerando que estas últimas posen un abordaje más teórico de la materia, mientras que la informática tiene siempre un costado práctico y aplicado, vinculado con los dispositivos electrónicos.

Otros, en cambio, consideran como subdisciplinas de la

informática a las Ciencias de la computación, la Ingeniería informática, los

Sistemas de información, la tecnología de la información y la Ingeniería

del software.

En todo caso, la informática como disciplina tiene que ver

con el procesamiento automático de la información a través de dispositivos

electrónicos y sistemas computacionales, dotados estos últimos de tres

funciones básicas: el ingreso de datos (entrada), el procesamiento de

datos y la transmisión de resultados (salida).

Características

de la informática

La informática, a grandes rasgos, puede caracterizarse de la

siguiente manera:

- Su

objeto de estudio puede resumirse en el tratamiento automatizado de

la información mediante sistemas digitales computarizados.

- Se

propone tanto el abordaje teórico como el práctico de los

sistemas informáticos, aunque no se trata de una ciencia experimental.

- Toma

en préstamo el lenguaje formal de la lógica y la matemática para

expresar las relaciones entre los sistemas de datos y las operaciones que

estos ejecutan.

- Es

una de las disciplinas científicas más jóvenes, surgida formalmente

en la segunda mitad del siglo XX.

Historia

de la informática

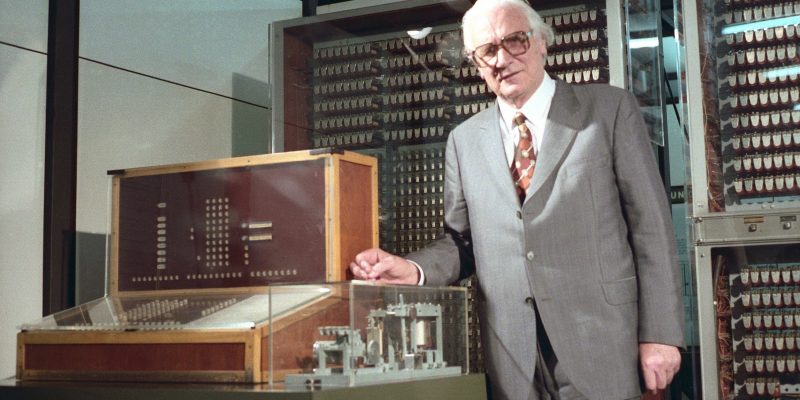

Konrad Zuse inventó la primera computadora llamada z3.

Al contrario de lo que se cree, la informática es anterior a

la invención de los computadores. Posee muy antiguos antecedentes en las

máquinas de cálculo mentales de los filósofos de la antiguada griega, como

Euclides (c. 325-265 a. C.) y su famoso algoritmo, o bien en las calculadoras

mecánicas del siglo XVII y las máquinas programables del siglo XIX.

Sin embargo, en la primera mitad del siglo XX se creó

la tecnología necesaria para desarrollar las primeras computadoras. Entre

esos avances se encuentra el tubo al vacío, las puertas lógicas y los primeros

circuitos, lo cual inauguró un campo del saber que muy pronto revolucionó a

todos los demás y cambió la forma en que pensamos el trabajo.

También fue central el trabajo en algoritmos durante

las primeras tres décadas del siglo, bajo el genio de figuras como el

matemático británico Alan Turing (1912-1954). Por otro lado, el contexto de la

segunda guerra mundial impulsó a los primeros calculadores automáticos que se

dispusieron para descifrar los códigos de guerra del enemigo.

La primera máquina de cálculo totalmente programable y

automática fue inventada en 1941, llamada Z3, y en 1944 la primera máquina

electromecánica, en la Universidad de Harvard en Estados Unidos: la Mark I.

Desde entonces, los sistemas informáticos no cesaron de

cambiar. Se incorporaron nuevas tecnologías como los transitares, los

semiconductores y diversos mecanismos de almacenamiento de información, desde

las tarjetas perforadas hasta las primeras cintas magnéticas.

El primer computador de la historia fue el ENIAC (1946),

de la Universidad de Pensilvania, que ocupaba un cuarto completo. Fue el

primero de varias generaciones de sistemas informáticos por venir, cada vez más

pequeños y potentes.

Las primeras escuelas de computación, en el marco de las

universidades, surgieron entre las décadas de 1950 y 1960. Paralelamente la

industria informática, naciente pero poderosa, que permeó todas las demás áreas

del saber humano en apenas 60 años de desarrollo.

¿Para qué

sirve la informática?

Casi ningún aspecto de la vida cotidiana se mantiene al

margen del mundo digital.

La informática tiene como propósito clave el

almacenamiento y la recuperación de información, lo cual ha sido una de las

preocupaciones clave de la humanidad desde el inicio de los tiempos. En ese

sentido, el primer sistema de almacenamiento fue la escritura misma, que

permitía codificar mensajes y recuperarlos luego a través de marcas sobre una

superficie.

Vista así, la informática ha llevado ese mismo principio al

máximo, creando sistemas y aparatos que almacenen, produzcan, transmitan y

reproduzcan información de manera masiva, eficiente y veloz. No en balde la

informática interviene hoy en día en prácticamente todos los demás campos

del saber de un modo o de otro.

Importancia

de la informática

La importancia de la informática hoy en día no podría ser

más evidente. En un mundo hiper teologizado e hiperconectado, la

información se ha convertido en uno de los activos más preciados del

mundo, y los complejos sistemas informáticos que hemos construido nos permiten

administrarlo de manera más veloz y eficiente que nunca antes en la historia.

La computación es una de las disciplinas de mayor

demanda en el mercado universitario del mundo. Tiene la mayor y más rápida

salida laboral, dado que casi ningún aspecto de la vida cotidiana se mantiene

al margen todavía del mundo digital y de los grandes sistemas de procesamiento

de información.

La big data (o “gran información”) que nuestros

dispositivos reúnen de nosotros es evidencia de ello: vivimos realmente en la

era de la información, y la informática entonces no podría ser más importante.

Conceptos

básicos de informática

El software de aplicación ofrece funciones que van desde el

trabajo hasta el ocio.

Los conceptos más básicos de la informática son

el hardware y el software.

El hardware es el aspecto físico, rígido, concreto y

tangible de los sistemas informáticos. Son, así, las piezas y componentes que

podemos tocar, intercambiar, romper, etc., algo así como el “cuerpo” de la

computadora.

En dicha categoría se incluyen los componentes vitales de

procesamiento (como el procesador de cálculo) o los dispositivos de

almacenamiento(la memoria y los discos rígidos), pero también los

dispositivos periféricos, que son aditamentos independientes del sistema, que

se conectan con él para permitirle desempeñar diversas funciones.

Dependiendo de cuáles sean dichas funciones, podremos hablar

de:

- Dispositivos de entrada. Aquellos

que permiten introducir información al sistema, como puede ser un teclado,

un ratón, una cámara web o un escáner.

- Dispositivos de salida. Aquellos

que permiten extraer o recuperar información del sistema, como pueden ser

el monitor, una impresora o unos parlantes.

- Dispositivos salida/entrada. Aquellos que son

capaces de desempeñar ambas funciones a la vez o de manera sucesiva, como

puede ser una impresora multifuncional, o un monitor táctil.

El software vendría a ser la mente del sistema

informático, intangible, abstracto y sólo accesible a través del sistema.

Existen muchísimos tipos de software, algunos de los cuales vienen ya preinstalados

en sectores críticos de la computadora, mientras que otros sirven de interfaz

entre el sistema y los usuarios, gobernando los dispositivos, controlando los

recursos y permitiendo la instalación de programas secundarios que el

usuario desee.

Así, podemos hablar de:

- Software operativo o sistemas

operativos. Aquellos

programas que se necesitan para el funcionamiento mínimo del sistema y

para que el usuario pueda disponer de sus recursos. Se trata de los

programas fundamentales que proveen al usuario de un entorno de

operaciones y que regulan el acceso a los recursos físicos del sistema,

como la memoria, el procesador, etc.

- software de aplicación. Aquellos programas

que el usuario instala en el sistema posteriormente y que le ofrecen

determinadas funciones, que van desde el trabajo hasta el ocio:

videojuegos, procesadores de texto, programas de diseño gráfico, programas

antivirus, exploradores de la red, etc.

Tecnología

informática

Se entiende por tecnología informática al estudio,

desarrollo, gerencia y puesta en práctica de sistemas informáticos automatizados,

especialmente desde la perspectiva del software.

Así, los especialistas en tecnología informática se dedican a distintas áreas de la actividad computarizada, como son el diseño de software, el establecimiento de redes informáticas, la gerencia de sistemas computarizados, el diseño de bases de datos, etc. Su propósito es el de facilitar la implementación de estas tecnologías en los ámbitos empresariales, productivos u organizacionales.

No hay comentarios:

Publicar un comentario